La musique est paradoxalement aussi naturelle à écouter que difficile à définir. En effet, perçue sans effort par le cerveau, elle est pourtant le fruit d’un assemblage complexe de notes, de timbres et de rythmes qui varient en outre selon les cultures et les époques. Cette complexité acoustique structurelle ainsi que la variété des émotions que la musique porte s’accompagnent d’un traitement cognitif sophistiqué qui n’est pas encore bien compris de nos jours.

La musique, une création culturelle humaine ?

La musique est universelle, en cela qu’on observe sa présence dans toutes les cultures, à toutes les époques connues depuis les sociétés préhistoriques et l’établissement d’humains modernes en Europe il y a 40 000 ans [1]. Par exemple, une flûte en os de vautour datant de cette époque a été retrouvée en Allemagne [2]. Pourquoi la musique existe-t-elle dans la culture humaine ? C’est un vaste débat encore ouvert1 [3]. Néanmoins, même si, par exemple, les oiseaux et les baleines chantent2 [6], la musique utilisant des instruments est une forme élaborée exclusivement humaine [7, 8]. En outre, même si de nombreux animaux sont sensibles à la musique [9] et que les souris, les singes et les poissons, par exemple, comme probablement la plupart des vertébrés [10–12], peuvent facilement distinguer deux notes de musique, leur capacité à discriminer des composantes plus complexes de la musique reste incertaine [13].

Les ethnomusicologistes considèrent souvent la musique comme une construction non seulement humaine mais exclusivement culturelle (et à ce titre, pas complètement universelle) [14]. Sa définition et son usage varient selon les cultures et les traditions des peuples : en Afrique, certaines tribus ne la distinguent pas fondamentalement du chant et de la danse, et d’autres la considèrent comme une part intégrante de la communication ou des rites sociaux [15]. Sa forme varie également. D’une part géographiquement : les musiques traditionnelles asiatiques, ou encore de tribus indiennes ou africaines sonnent parfois curieusement aux oreilles « occidentales » en raison de différences dans les rythmes [16], placements de notes [17] et instruments. D’autre part selon les époques et les générations, parfois très rapprochées : les préférences et productions musicales en France favorisent la pop rock dans les années 60, le disco à la fin des années 70, le rap et la dance dans les années 90, dont les rythmes, instruments et messages diffèrent fondamentalement.

Comment définir la musique et ce que l’on en perçoit ?

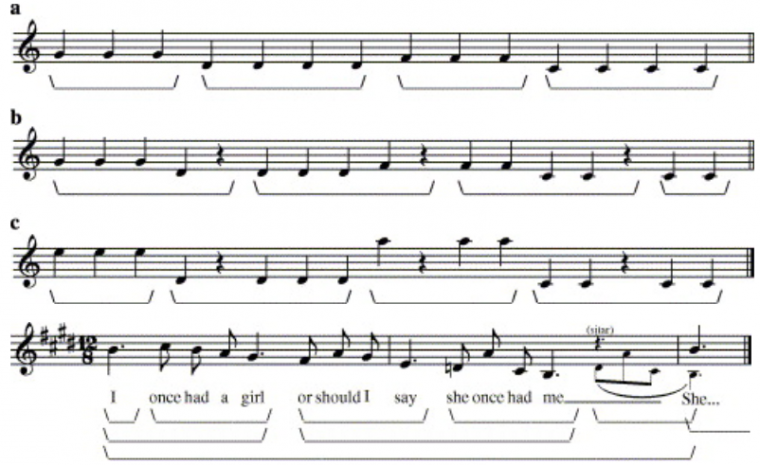

Malgré ces divergences, certaines bases structurelles sont communes ou majoritaires dans toutes les musiques, comme le chant, un petit nombre de notes, certains intervalles simples entre notes et l’existence de pulsations [14, 18, 19]. En fait, la musique, tout comme chaque langage, est constituée d’une « syntaxe » relativement universelle, qui gouverne la manière dont les éléments musicaux (notes, pulsations) peuvent être combinés et exprimés séquentiellement pour créer accords, mélodies et rythmes [20]. Cette syntaxe n’est pas aussi rigide que dans un langage, elle joue des contrastes et des rapprochements de notes et de rythmes pour créer des regroupements perceptifs et la sensation d’écouter de la musique (Fig. 1).

Alors que ces différentes portées correspondent juste à une succession de notes, un individu va, à l’écoute, reconnaître différents regroupements. Cette tendance à regrouper ensemble des objets proches plutôt qu’à les percevoir comme une simple juxtaposition d’éléments illustre le principe de proximité de type Gestalt [21]. Ces regroupements opérés de manière automatique, non consciente, permettent à l’individu de donner « un sens » à ce qui n’est en définitive qu’une succession de sons de fréquences différentes.

a) À l’écoute, les mêmes notes semblent former des regroupements ; b) il y a un saut de note mais la pause crée une grande distance entre les notes, c’est elle qui crée ici les regroupements ; c) le saut de note est si grand que c’est lui, et non la pause, qui crée des regroupements ; dernière ligne : première notes de Norwegian wood des Beatles : les pauses et les proximités de notes créent des regroupements progressifs imbriqués les uns dans les autres et ne suivant pas toujours les mesures de séparation. Adapté de [22].

Indépendamment de la manière de produire de la musique (instruments, chant…), la perception qu’un morceau est une musique provient de l’identification par le cerveau de cette syntaxe : faire suivre des notes au hasard ne crée pas une mélodie reconnue comme plaisante par la plupart des gens. C’est d’ailleurs, avec la mélodie et le rythme, le troisième aspect majeur de la musique : elle provoque des sensations, elle interagit avec nos émotions [22], et dans ce cadre, la culture joue un rôle essentiel : le fado tirera des larmes aux Portugais mais pourra laisser de marbre des Polonais.

Vers une interprétation biologique de la perception musicale

Ces trois aspects majeurs et universels de la musique permettent d’envisager que la musique « est dans notre nature » [23] : il existerait un traitement cognitif spécifique et inné de la musique chez les humains. Cette approche biologique de la perception musicale est relativement récente [24] et moins évidente qu’il n’y paraît. En effet, la perception de la musique par le cerveau ne peut pas être simple car beaucoup d’aspects rentrent en jeu simultanément, par exemple :

-

la perception des différentes composantes de la musique : les rythmes, la hauteur des notes, les combinaisons simultanées de notes donnant des accords [25] ;

-

la perception et la distinction des instruments utilisés, dont la différence acoustique est appelée « timbre » : une même note jouée par un piano et un violon diffèrent par leur timbre, c’est-à-dire la répartition de l’énergie entre les fréquences multiples (appelée harmoniques) de la note de base (appelée fondamentale) ;

-

la mémoire immédiate ou de long terme pour comprendre une mélodie, reconnaître un couplet, un refrain, se rappeler un morceau connu : par exemple, percevoir un rythme implique d’avoir mémorisé et reconnu la différence temporelle entre deux pulsations ;

-

la prédiction par le cerveau des futures notes et arrangements : on peut reconnaître implicitement la gamme du morceau et prédire la note1 terminant la mélodie, c’est-à-dire la célèbre « résolution » en musique [27] ;

-

Les émotions liées à l’écoute pure du morceau, au souvenir accompagnant une écoute passée ou aux sensations donnant envie de danser par exemple ;

-

le texte d’une chanson dont le sens et le rythme interagissent avec la musique.

On se demande donc bien par où commencer l’étude cérébrale de la perception musicale ! En même temps, voir des animaux suivre des rythmes ou même danser (chiens, perroquets) suggère que certains mécanismes communs à de nombreuses espèces permettent de percevoir au moins certaines composantes de la musique comme le rythme.

Le traitement des sons et de la musique par le système auditif

En fait, comme tout son, la musique est d’abord traitée par le système auditif, dont l’organisation est commune à tous les mammifères2. Pour résumer, le son est une variation de pression de l’air transmise par le conduit auditif externe vers le tympan puis la chaîne d’osselets (rôle d’amplification) et enfin la cochlée. Cet organe spiralaire transforme, via les cellules ciliées, cette variation de pression en une activité électrique pouvant être transmise par des neurones3 : c’est la transduction mécano-électrique.

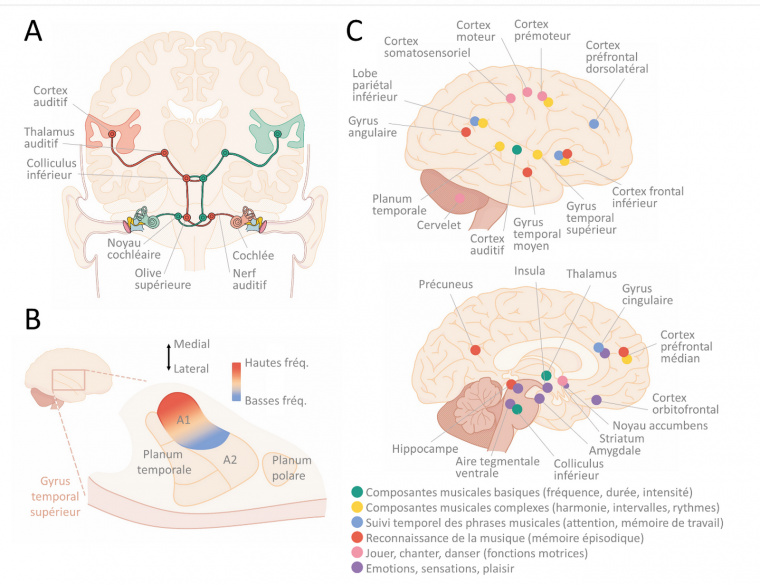

La cochlée décompose les sons en composantes fréquentielles. Autrement dit, elle sépare les sons des plus graves aux plus aigus, avant que cette information ne se transmette jusqu’au cerveau via des fibres nerveuses et des neurones concentrés dans plusieurs noyaux sous-corticaux : le ganglion spiral, le noyau cochléaire, l’olive supérieure, le lemnisque latéral, le colliculus inférieur, le thalamus auditif (Figure 2A). Chacun de ces noyaux transforme progressivement l’information sonore et en traite déjà certains aspects. Par exemple, l’olive supérieure compare l’information venant des oreilles gauche et droite pour en déduire la localisation spatiale du son (permettant d’apprécier un effet musical « stéréo »). Après le thalamus, l’information atteint le cortex auditif primaire (A1), premier relais auditif du néocortex situé dans le gyrus supérieur du lobe temporal. Le système auditif est le plus rapide des systèmes sensoriels, il peut transcrire des modifications temporelles plus rapides qu’une milliseconde (ms) et fait parvenir cette information du tympan vers A1 en moins de 25 ms chez l’humain ! Cette vitesse permet de détecter rapidement des sons d’alerte, ou de suivre les riches variations temporelles des vocalisations, de la parole et de la musique.

La décomposition des sons en fréquences issue de la cochlée se maintient jusqu’à A1 (le phénomène est appelé tonotopie [28]), dont les neurones répondent donc préférentiellement à une gamme de fréquences réduite. Autour de A1, dans le gyrus supérieur du lobe temporal, on trouve une première ceinture de zones auditives associatives (« belt ») pouvant intégrer des informations d’autres zones du cerveau (par exemple visuelles), puis une seconde ceinture de zones encore plus associatives (« parabelt ») [29], voir Figure 2B. La taille de ces zones et leur organisation diffèrent cette fois entre les mammifères. Le cortex auditif (A1 + belt + parabelt) est connecté à de nombreuses autres zones cérébrales (hippocampe, cortex frontal, striatum, aires multimodales…) stockant, traitant ou interprétant l’information qui en est issue.

Même si l’on sait que le cortex auditif est nécessaire pour traiter l’information sonore, le rôle de toutes les zones susnommées dans le traitement des sons et a fortiori de la musique n’est pas complètement éclairci. La hauteur des sons (notes) serait traitée grâce à la tonotopie par A1, ainsi que par le planum temporale (belt) [30]. Lorsque les notes s’enchaînent en mélodie, l’activation se déplace vers des zones plus latérales et antérieures dans le cortex auditif [31]. Enfin, à mesure que des composantes plus complexes sont détectées (tonalité, rythmes complexes) ou que le recours à la mémoire et à l’attention augmentent, des zones frontales médiales et inférieures sont également activées en plus du gyrus temporal supérieur [32] (voir section suivante et Figure 2C). De manière générale, de nombreuses études ont observé une latéralisation du traitement de la musique, avec une activation plus forte de l’hémisphère droit [30, 33–35].

A : Schéma des voies auditives depuis le tympan et la cochlée jusqu’au cortex auditif. D’après [36]. B : le cortex auditif, situé dans le lobe temporal, comprend une zone primaire (A1) organisée de manière tonotopique entre basses et hautes fréquences, puis diverses zones associatives autour formant deux ceintures successives (belt en rose foncé, parabelt en rose clair). D’après [37]. C : Zones cérébrales activées par l’écoute, la lecture ou la production de musique. D’après [38]. Illustration par Jérémie Luciani.

Le lieu où la musique est mémorisée n’est pas encore bien compris, et n’est probablement pas unique. On a observé qu’écouter de la musique connue et l’imaginer ne sont pas des processus cérébraux si différents, ils activent de nombreuses zones similaires dans le lobe temporal et la zone préfrontale inférieure [39–42]. Ces zones stockeraient donc une partie au moins de la mémoire musicale. Mais on peut aussi supposer qu’imaginer la musique provoque tout simplement le même traitement cérébral que l’écouter (Figure 3) !

Le vert indique un recouvrement entre les deux processus. Adapté de [42]. Crédits : “Neuronal Correlates of Perception, Imagery, and Memory for Familiar Tunes” by Sibylle C. Herholz, Andrea R. Halpern and Robert J. Zatorre in Journal of Cognitive Science, Volume 23, issue 6, June 2012, figure 2, reprinted courtesy of The MIT Press.

Interprétation des résultats d'IRMf

Les investigations menées en imagerie fonctionnelle visent à caractériser les zones cérébrales davantage activées lors de la condition test (sujet soumis au stimulus étudié) que lors d'une situation basale, qui sert de référence (où le sujet n'est pas soumis au stimulus étudié). Sur les résultats d'IRMf, les zones en couleur représentent les zones probablement (et non certainement) plus activées pendant le test. L'un des tests statistiques les plus utilisés pour calculer cette probabilité est le test t de Student. Plus les valeurs obtenues sont élevées et plus la probabilité que la différence entre la condition test et la condition témoin soit significative est forte.

Existe-t-il des aires cérébrales spécialisées dans la musique ?

C’est la question qui taraude les chercheurs depuis longtemps. Il existe en fait deux hypothèses principales quant à la manière dont le cerveau perçoit la musique [23, 43]. Dans la première, il n’existerait pas d’aire spécialisée dans le traitement des musiques : les humains utiliseraient les capacités naturelles d’apprentissage et de plasticité du cerveau, c’est-à-dire qu’ils se serviraient de circuits cérébraux dédiés à d’autres fonctions pour traiter, apprécier, apprendre et produire la musique. Dans la seconde hypothèse, il existerait des circuits dédiés à la perception de la musique chez l’être humain. Ils seraient donc guidés par une évolution récente et gouvernés par les gènes. Pour départager ces deux hypothèses, il faut déterminer si les zones du cerveau qui répondent à la musique correspondent à des zones connues pour effectuer d’autres fonctions ou s’il s’agit de structures traitant de façon exclusive les informations musicales.

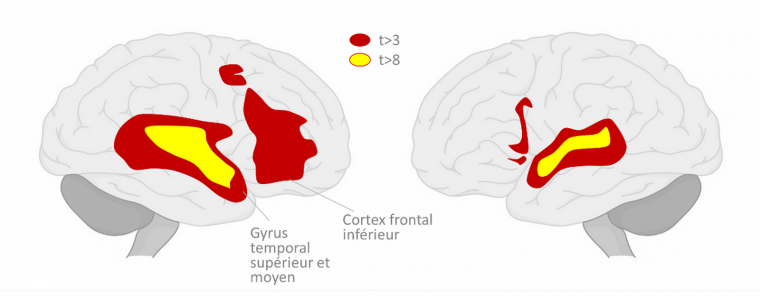

En accord avec la première hypothèse, les chercheurs ont identifié des aires cérébrales servant à la fois pour le traitement du langage et de la musique (Figure 4). Globalement, c’est le cas du cortex frontal inférieur (CFI) et du gyrus temporal supérieur et moyen (parties postérieures et antérieures) [44].

On observe de fortes réponses dans le cortex frontal inférieur et le gyrus supérieur et moyen temporal. Les zones colorées correspondent aux aires cérébrales qui sont aussi bien activées lors de l’écoute de paroles que lors de celle d’une musique. On observe ici une activation plus forte et plus étendue dans l’hémisphère droit que dans le gauche. D’après [44].

Dans cette hypothèse, la théorie dite « des ressources d’intégration syntaxique partagées » [45] propose que le traitement syntaxique du langage et de la musique partagent un ensemble commun de ressources neurales localisées dans les régions antérieures du cortex temporal supérieur [46, 47] et dans le cortex préfrontal, plus particulièrement le cortex frontal inférieur. Ainsi, les études comparant la réponse cérébrale à de la musique classique et à sa version dégradée (le morceau étant coupé en intervalles de 300 ms permutés aléatoirement) ont montré l’implication de zones antérieures et orbitales du cortex frontal inférieur, autour du gyrus préfrontal inférieur [48, 49]. En outre, le traitement des irrégularités tonales et harmoniques impliquerait des zones « linguistiques » connues du cortex frontal inférieur [50–52] : des régions ventrales-antérieures (pars opercularis et gyrus préfrontal inférieur) impliquées dans le traitement syntaxique et sémantique [53, 54] et des régions dorsales-postérieures (pars opercularis et pars triangularis, constituant ensemble l’aire de Broca, dans l’hémisphère gauche) impliquées dans le traitement phonologique et syntaxique. Le cas de l’aire de Broca est intéressant : on sait depuis longtemps qu’elle est importante pour la production du langage, et qu’elle s’active également en présence d’une violation d’une règle grammaticale, par exemple si l’on dit « Bill a écrit papier un. » [55]. Une étude récente a montré que cette zone, mais aussi son équivalent de l’hémisphère droit dont la fonction est mal connue, s’activaient en présence de « violations » locales de règles musicales (Figure 5) [56].

Dans une phrase « grammaticale », A1 est en miroir de B1 et A2 en miroir de B2. Dans les deux exemples de phrases « non grammaticales », soit B2 va dans le même sens que A2 (en haut), soit B2 n’est pas du même type que A2 (en bas). Lors de l’écoute de phrases non grammaticales, différentes aires cérébrales sont activées (en rouge) dont l’aire de Broca et son équivalent dans l’hémisphère droit. Les zones colorées en bleu correspondent à d’autres conditions expérimentales non étudiées ici. Adapté de [56].

Preuve de la complexité et la modularité des aires associées à la musique, l’écriture musicale semble distincte de la production du langage ou du traitement de la musique : le célèbre compositeur Maurice Ravel a souffert à partir de 1933 d’une maladie neurodégénérative qui l’a empêché d’écrire des partitions de musique alors qu’il se rappelait parfaitement ses compositions passées et avait même son futur opéra, jamais écrit, dans sa tête [57, 58]. À l’inverse, le compositeur russe Shebalin fut victime d’une attaque cérébrale en 1953 qui le laissa dans l’incapacité de parler ou comprendre la parole alors même qu’il ne cessa jamais d’écrire des partitions [26].

En accord avec la deuxième hypothèse, des chercheurs du MIT ont identifié en 2015 une population neuronale (bilatérale) qui ne répondrait exclusivement qu’à la musique, et dont la réponse est dégradée lorsque l’on détruit la structure musicale du morceau [43]. Cette population est située dans le cortex temporal, antérieurement au cortex auditif. Une hypothèse moins forte est proposée par divers auteurs, postulant que des réseaux neuronaux spécifiques et peut-être typiquement humains traitent des composantes de la musique, principalement dans le lobe temporal et le cortex frontal inférieur [20, 23, 59, 60]. Par exemple, l’encodage de la hauteur des notes et de leur variation pourrait être un « module » spécialisé et indépendant du langage car la compréhension de celui-ci ne dépend pas des « notes » utilisées (par exemple, on peut comprendre une phrase même si elle est chantée). Une manière d’aborder le problème est d’étudier les sujets montrant un déficit nommé « amusie », c’est-à-dire une incapacité à reconnaître et mémoriser la hauteur des notes dans la musique [61].

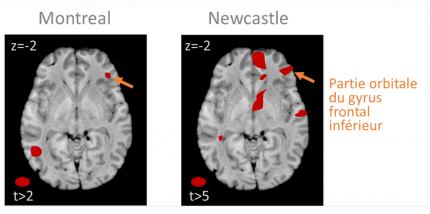

Les zones colorées correspondent à des zones où une augmentation de concentration de matière blanche est associée à une augmentation du score au test de violation mélodique. Ces résultats, obtenus à partir de mesures réalisées chez des patients amusiques et témoins, indiquent qu’une cause de l’amusie pourrait provenir d’une faible concentration en matière blanche du cortex frontal inférieur de ces sujets, marqué d’une flèche jaune sur les images cérébrales. D’après [71].

Les sujets « amusiques » (peut-être jusqu’à 4 % des humains hors lésions [62]) ne détectent pas les notes fausses dans une mélodie, ne distinguent pas toujours deux mélodies, ne peuvent suivre un rythme et trouvent par exemple tout à fait neutres ou plaisantes des mélodies dissonantes absolument désagréables pour la majorité des gens ! Ceci avec des niveaux normaux d’intelligence ou de traitement du langage par ailleurs. L’amusie peut être la conséquence d’une lésion cérébrale [63] ou d’une anomalie neurale congénitale. Des lésions du lobe temporal (plus souvent à droite) peuvent provoquer une amusie [64–68], mais chez certains de ces sujets, la capacité à distinguer des notes ou même des séquences de notes reste préservée, ce qui indique qu’il existe bien plusieurs « modules » dans la perception de la musique. Dans les études d’imagerie chez des sujets ayant une amusie congénitale (donc probablement d’origine génétique), des déficits du lobe temporal sont parfois envisagés [69, 70], mais ce sont surtout des déficits volumétriques du cortex frontal inférieur (Figure 6) et de sa connectivité avec le cortex auditif qui sont pointés du doigt [69, 71, 72]. Ceci est cohérent avec le rôle du cortex frontal inférieur dans la mémoire de travail associée à la hauteur de son [35] et dans la perception des violations harmoniques [51, 73]. On peut également aborder le problème des « modules » neuronaux spécialisés dans le traitement de composantes de la musique par la biologie comparative. Une étude récente a ainsi trouvé chez les humains davantage de régions du lobe temporal préférant les sons harmoniques, très présents dans le langage et la musique, que chez les macaques [74].

Les émotions portées par la musique

Environ 80 % des adultes ressentent des émotions physiques visibles (frissons, joies, peurs, pleurs) à l’écoute de la musique [75]. Celles-ci sont mesurables via des variations de la fréquence cardiaque, de la pression artérielle, de la température corporelle (musiques tristes) ou de la respiration (musiques joyeuses) [76]. Il faut y ajouter des émotions plus complexes, touchant au plus profond des êtres, liées par exemple à des souvenirs personnels.

Dans le cerveau, les émotions portées par la musique seraient davantage associées à l’activité du lobe frontal ou des systèmes limbiques et paralimbiques, classiquement associés aux émotions, qu’au lobe temporal. Les circuits impliqués peuvent en fait grandement varier selon le type d’émotion, même pour des objets musicaux acoustiquement proches. Par exemple, les intervalles musicaux consonants1 évoquent des sensations agréables et activent l’aire orbitofrontale de l’hémisphère droit et une partie du corps calleux. À l’inverse, les accords dissonants activent davantage le gyrus parahippocampal [77]. De manière générale, les musiques très plaisantes activent les régions du cerveau impliquées dans la récompense/motivation, les émotions et l'excitation, notamment le striatum ventral, le mésencéphale, l'amygdale, le cortex orbitofrontal et le cortex préfrontal ventral médian [78]. Ces structures cérébrales sont aussi connues pour être activées par d'autres stimuli induisant l'euphorie et l’addiction, tels que la nourriture, le sexe et les drogues !

En conclusion

En simplifiant, la partie supérieure du lobe temporal, siège du cortex auditif, permet de traiter les composantes les plus fondamentales de la musique (notes, rythmes, mélodies) tandis que le lobe frontal, et plus particulièrement le cortex frontal inférieur, semble communiquer avec le lobe temporal pour identifier, traiter et percevoir les composantes plus complexes de la musique comme sa syntaxe. La perception de la musique par le cerveau reste cependant mal connue, peut-être en raison de sa structure acoustique complexe et parce que les modèles animaux se prêtent mal à l’étude de cette pure création culturelle humaine.

Ressources complémentaires sur le sujet « Entendre la musique »

- Un article de Wikipédia sur la neuroscience de la musique (en anglais)

- Le site de l'University of Central Florida présente de manière très simplifiée, mais illustrative, une liste des zones cérébrales activées par la musique

- Un article sur les modifications cérébrales induites par la pratique musicale, qui comprend de nombreux schémas explicatifs

- Des outils pédagogiques avec des données réelles d’imagerie, à utiliser dans le cadre de TP par exemple

Références

- d’Errico, F., Henshilwood, C., Lawson, G., Vanhaeren, M., Tillier, A.-M., Soressi, M., Bresson, F., Maureille, B., Nowell, A., Lakarra, J., Backwell, L., Julien, M.: Archaeological Evidence for the Emergence of Language, Symbolism, and Music–An Alternative Multidisciplinary Perspective. J. World Prehistory. 17, 1–70 (2003). https://doi.org/10.1023/A:1023980201043

- Musique préhistorique, https://fr.wikipedia.org/w/index.php?title=Musique_pr%C3%A9historique&oldid=169022407, (2020)

- Hauser, M.D., McDermott, J.: The evolution of the music faculty: a comparative perspective. Nat. Neurosci. 6, 663–668 (2003). https://doi.org/10.1038/nn1080

- Fitch, W.T.: The biology and evolution of music: A comparative perspective. Cognition. 100, 173–215 (2006). https://doi.org/10.1016/j.cognition.2005.11.009

- Tinbergen, N.: On aims and methods of Ethology. Z. Für Tierpsychol. 20, 410–433 (1963). https://doi.org/10.1111/j.1439-0310.1963.tb01161.x

- Gray, P.M., Krause, B., Atema, J., Payne, R., Krumhansl, C., Baptista, L.: The Music of Nature and the Nature of Music. Science. 291, 52–54 (2001). https://doi.org/10.1126/science.10.1126/SCIENCE.1056960

- Stalinski, S.M., Schellenberg, E.G.: Music cognition: a developmental perspective. Top. Cogn. Sci. 4, 485–497 (2012). https://doi.org/10.1111/j.1756-8765.2012.01217.x

- Stevens, C.J.: Music perception and cognition: a review of recent cross-cultural research. Top. Cogn. Sci. 4, 653–667 (2012). https://doi.org/10.1111/j.1756-8765.2012.01215.x

- Panksepp, J., Bernatzky, G.: Emotional sounds and the brain: the neuro-affective foundations of musical appreciation. Behav Process. 60, 133–155 (2002). https://doi.org/S0376635702000803 [pii]

- Lewis, E.R.: Speculations about noise and the evolution of vertebrate hearing. Hear. Res. 25, 83–90 (1987). https://doi.org/10.1016/0378-5955(87)90082-7

- Fay, R.R.: HEARING AND LATERAL LINE | Psychoacoustics: What Fish Hear. In: Farrell, A.P. (ed.) Encyclopedia of Fish Physiology. pp. 276–282. Academic Press, San Diego (2011)

- de Hoz, L., Nelken, I.: Frequency tuning in the behaving mouse: different bandwidths for discrimination and generalization. PloS One. 9, e91676 (2014). https://doi.org/10.1371/journal.pone.0091676

- D’Amato, M.R.: A Search for Tonal Pattern Perception in Cebus Monkeys: Why Monkeys Can’t Hum a Tune. Music Percept. 5, 453–480 (1988). https://doi.org/10.2307/40285410

- Nettl, B.: An Ethnomusicologist Contemplates Universals in Musical. Sound and Musical Culture. In: Wallin, N.L., Merker, B., and Brown, S. (eds.) The Origins of Music. pp. 463–472. Massachusett s Institute of Technology Press, London (2000)

- Wiggins, T.: Globalisation. L’Afrique occidentale dans le monde ou le monde en Afrique occidentale. Cah. D’ethnomusicologie Anciennement Cah. Musiques Tradit. 189–200 (1996)

- Anku, W.: Principles of Rhythm Integration in African Drumming. Black Music Res. J. 17, 211–238 (1997). https://doi.org/10.2307/779369

- London, J., Polak, R., Jacoby, N.: Rhythm histograms and musical meter: A corpus study of Malian percussion music. Psychon. Bull. Rev. 24, 474–480 (2017). https://doi.org/10.3758/s13423-016-1093-7

- Carterette, E.C., Kendall, R.A.: 18 - Comparative Music Perception and Cognition. In: Deutsch, D. (ed.) The Psychology of Music (Second Edition). pp. 725–791. Academic Press, San Diego (1999)

- Dowling, W.J., Harwood, J.L.: Music Cognition. Academic Press (1986)

- Lerdahl, F., Jackendoff, R.S.: A Generative Theory of Tonal Music, reissue, with a new preface. MIT Press (1996)

- Principles of grouping, https://en.wikipedia.org/w/index.php?title=Principles_of_grouping&oldid=950323007, (2020)

- Jackendoff, R., Lerdahl, F.: The capacity for music: what is it, and what’s special about it? Cognition. 100, 33–72 (2006). https://doi.org/10.1016/j.cognition.2005.11.005

- Peretz, I.: The nature of music from a biological perspective. Cognition. 100, 1–32 (2006). https://doi.org/10.1016/j.cognition.2005.11.004

- Wallin, N.L., Merker, B., Brown, S.: The Origins of Music. MIT Press (2001)

- Warren, J.: How does the brain process music? Clin. Med. Lond. Engl. 8, 32–36 (2008). https://doi.org/10.7861/clinmedicine.8-1-32

- Weinberger, N.M.: Music And The Brain, https://www.scientificamerican.com/article/music-and-the-brain-2006-09/

- Résolution (musique)., http://www.cosmovisions.com/musiResolution.htm

- Tonotopy, https://en.wikipedia.org/w/index.php?title=Tonotopy&oldid=968167982, (2020)

- Auditory cortex, https://en.wikipedia.org/w/index.php?title=Auditory_cortex&oldid=966826580, (2020)

- Hyde, K.L., Peretz, I., Zatorre, R.J.: Evidence for the role of the right auditory cortex in fine pitch resolution. Neuropsychologia. 46, 632–639 (2008). https://doi.org/10.1016/j.neuropsychologia.2007.09.004

- Patterson, R.D., Uppenkamp, S., Johnsrude, I.S., Griffiths, T.D.: The Processing of Temporal Pitch and Melody Information in Auditory Cortex. Neuron. 36, 767–776 (2002). https://doi.org/10.1016/S0896-6273(02)01060-7

- Janata, P., Birk, J.L., Horn, J.D.V., Leman, M., Tillmann, B., Bharucha, J.J.: The Cortical Topography of Tonal Structures Underlying Western Music. Science. 298, 2167–2170 (2002). https://doi.org/10.1126/science.1076262

- Evers, S., Dannert, J., Rödding, D., Rötter, G., Ringelstein, E.B.: The cerebral haemodynamics of music perception. A transcranial Doppler sonography study. Brain J. Neurol. 122 ( Pt 1), 75–85 (1999). https://doi.org/10.1093/brain/122.1.75

- Griffiths, T.D., Johnsrude, I., Dean, J.L., Green, G.G.: A common neural substrate for the analysis of pitch and duration pattern in segmented sound? Neuroreport. 10, 3825–3830 (1999). https://doi.org/10.1097/00001756-199912160-00019

- Zatorre, R.J., Evans, A.C., Meyer, E.: Neural mechanisms underlying melodic perception and memory for pitch. J. Neurosci. Off. J. Soc. Neurosci. 14, 1908–1919 (1994)

- Purves, D., Williams, S.M.: Neuroscience. Sinauer Associates, Sunderland, Mass. (2001)

- Semple, M.N., Scott, B.H.: Cortical mechanisms in hearing. Curr. Opin. Neurobiol. 13, 167–173 (2003). https://doi.org/10.1016/S0959-4388(03)00048-5

- Särkämö, T., Tervaniemi, M., Huotilainen, M.: Music perception and cognition: development, neural basis, and rehabilitative use of music. WIREs Cogn. Sci. 4, 441–451 (2013). https://doi.org/10.1002/wcs.1237

- Halpern, A.R., Zatorre, R.J.: When that tune runs through your head: a PET investigation of auditory imagery for familiar melodies. Cereb. Cortex N. Y. N 1991. 9, 697–704 (1999). https://doi.org/10.1093/cercor/9.7.697

- Halpern, A.R., Zatorre, R.J., Bouffard, M., Johnson, J.A.: Behavioral and neural correlates of perceived and imagined musical timbre. Neuropsychologia. 42, 1281–1292 (2004). https://doi.org/10.1016/j.neuropsychologia.2003.12.017

- Zatorre, R.J., Halpern, A.R., Perry, D.W., Meyer, E., Evans, A.C.: Hearing in the mind’s ear: a PET investigation of musical imagery and perception. J Cogn Neurosci. 8, 29–46 (1996)

- Herholz, S.C., Halpern, A.R., Zatorre, R.J.: Neuronal correlates of perception, imagery, and memory for familiar tunes. J. Cogn. Neurosci. 24, 1382–1397 (2012). https://doi.org/10.1162/jocn_a_00216

- Norman-Haignere, S., Kanwisher, N.G., McDermott, J.H.: Distinct Cortical Pathways for Music and Speech Revealed by Hypothesis-Free Voxel Decomposition. Neuron. 88, 1281–1296 (2015). https://doi.org/10.1016/j.neuron.2015.11.035

- Abrams, D.A., Bhatara, A., Ryali, S., Balaban, E., Levitin, D.J., Menon, V.: Decoding Temporal Structure in Music and Speech Relies on Shared Brain Resources but Elicits Different Fine-Scale Spatial Patterns. Cereb. Cortex. 21, 1507–1518 (2011). https://doi.org/10.1093/cercor/bhq198

- Patel, A.D.: Language, music, syntax and the brain. Nat. Neurosci. 6, 674–681 (2003). https://doi.org/10.1038/nn1082

- Koelsch, S.: Neural substrates of processing syntax and semantics in music. Curr. Opin. Neurobiol. 15, 207–212 (2005). https://doi.org/10.1016/j.conb.2005.03.005

- Callan, D.E., Tsytsarev, V., Hanakawa, T., Callan, A.M., Katsuhara, M., Fukuyama, H., Turner, R.: Song and speech: brain regions involved with perception and covert production. NeuroImage. 31, 1327–1342 (2006). https://doi.org/10.1016/j.neuroimage.2006.01.036

- Levitin, D.J., Menon, V.: Musical structure is processed in “language” areas of the brain: a possible role for Brodmann Area 47 in temporal coherence. NeuroImage. 20, 2142–2152 (2003). https://doi.org/10.1016/j.neuroimage.2003.08.016

- Levitin, D.J., Menon, V.: The Neural Locus of Temporal Structure and Expectancies in Music: Evidence From Functional Neuroimaging At 3 Tesla. Music Percept. 22, 563–575 (2005). https://doi.org/10.1525/mp.2005.22.3.563

- Maess, B., Koelsch, S., Gunter, T.C., Friederici, A.D.: Musical syntax is processed in Broca’s area: an MEG study. Nat. Neurosci. 4, 540–545 (2001). https://doi.org/10.1038/87502

- Koelsch, S., Gunter, T.C., v Cramon, D.Y., Zysset, S., Lohmann, G., Friederici, A.D.: Bach speaks: a cortical “language-network” serves the processing of music. NeuroImage. 17, 956–966 (2002)

- Janata, P.: Brain networks that track musical structure. Ann. N. Y. Acad. Sci. 1060, 111–124 (2005). https://doi.org/10.1196/annals.1360.008

- Bookheimer, S.: Functional MRI of language: new approaches to understanding the cortical organization of semantic processing. Annu. Rev. Neurosci. 25, 151–188 (2002). https://doi.org/10.1146/annurev.neuro.25.112701.142946

- Grodzinsky, Y., Friederici, A.D.: Neuroimaging of syntax and syntactic processing. Curr. Opin. Neurobiol. 16, 240–246 (2006). https://doi.org/10.1016/j.conb.2006.03.007

- Embick, D., Marantz, A., Miyashita, Y., O’Neil, W., Sakai, K.L.: A syntactic specialization for Broca’s area. Proc. Natl. Acad. Sci. U. S. A. 97, 6150–6154 (2000)

- Cheung, V.K.M., Meyer, L., Friederici, A.D., Koelsch, S.: The right inferior frontal gyrus processes nested non-local dependencies in music. Sci. Rep. 8, 3822 (2018). https://doi.org/10.1038/s41598-018-22144-9

- Dieguez, S.: L’opéra muet de Ravel, https://www.cerveauetpsycho.fr/sr/autour-oeuvre/lopera-muet-de-ravel-5784.php

- Caron, J.-L.: Maurice Ravel, victime d’une démence dégénérative « Aller + Loin « ResMusica, https://www.resmusica.com/2017/12/14/maurice-ravel-victime-dune-demence-degenerative-2/

- Dowling, W.J.: Perception of music. In: Blackwell handbook of perception. pp. 469–498. Blackwell Publishing, Malden (2001)

- Fedorenko, E., McDermott, J.H., Norman-Haignere, S., Kanwisher, N.: Sensitivity to musical structure in the human brain. J. Neurophysiol. 108, 3289–3300 (2012). https://doi.org/10.1152/jn.00209.2012

- Peretz, I., Hyde, K.L.: What is specific to music processing? Insights from congenital amusia. Trends Cogn. Sci. 7, 362–367 (2003). https://doi.org/10.1016/s1364-6613(03)00150-5

- Stewart, L.: Congenital amusia. Curr. Biol. 16, R904–R906 (2006). https://doi.org/10.1016/j.cub.2006.09.054

- Peretz, I.: Auditory atonalia for melodies. Cogn. Neuropsychol. 10, 21–56 (1993). https://doi.org/10.1080/02643299308253455

- Di Pietro, M., Laganaro, M., Leemann, B., Schnider, A.: Receptive amusia: temporal auditory processing deficit in a professional musician following a left temporo-parietal lesion. Neuropsychologia. 42, 868–877 (2004). https://doi.org/10.1016/j.neuropsychologia.2003.12.004

- Griffiths, T.D., Rees, A., Witton, C., Cross, P.M., Shakir, R.A., Green, G.G.: Spatial and temporal auditory processing deficits following right hemisphere infarction. A psychophysical study. Brain J. Neurol. 120 ( Pt 5), 785–794 (1997). https://doi.org/10.1093/brain/120.5.785

- Liégeois-Chauvel, C., Peretz, I., Babaï, M., Laguitton, V., Chauvel, P.: Contribution of different cortical areas in the temporal lobes to music processing. Brain J. Neurol. 121 ( Pt 10), 1853–1867 (1998). https://doi.org/10.1093/brain/121.10.1853

- Peretz, I., Kolinsky, R., Tramo, M., Labrecque, R., Hublet, C., Demeurisse, G., Belleville, S.: Functional dissociations following bilateral lesions of auditory cortex. Brain J. Neurol. 117 ( Pt 6), 1283–1301 (1994). https://doi.org/10.1093/brain/117.6.1283

- Steinke, W.R., Cuddy, L.L., Jakobson, L.S.: Dissociations among functional subsystems governing melody recognition after right-hemisphere damage. Cogn. Neuropsychol. 18, 411–437 (2001). https://doi.org/10.1080/02643290125702

- Albouy, P., Mattout, J., Bouet, R., Maby, E., Sanchez, G., Aguera, P.-E., Daligault, S., Delpuech, C., Bertrand, O., Caclin, A., Tillmann, B.: Impaired pitch perception and memory in congenital amusia: the deficit starts in the auditory cortex. Brain J. Neurol. 136, 1639–1661 (2013). https://doi.org/10.1093/brain/awt082

- Norman-Haignere, S.V., Albouy, P., Caclin, A., McDermott, J.H., Kanwisher, N.G., Tillmann, B.: Pitch-Responsive Cortical Regions in Congenital Amusia. J. Neurosci. Off. J. Soc. Neurosci. 36, 2986–2994 (2016). https://doi.org/10.1523/JNEUROSCI.2705-15.2016

- Hyde, K.L., Zatorre, R.J., Griffiths, T.D., Lerch, J.P., Peretz, I.: Morphometry of the amusic brain: a two-site study. Brain J. Neurol. 129, 2562–2570 (2006). https://doi.org/10.1093/brain/awl204

- Hyde, K.L., Zatorre, R.J., Peretz, I.: Functional MRI evidence of an abnormal neural network for pitch processing in congenital amusia. Cereb. Cortex N. Y. N 1991. 21, 292–299 (2011). https://doi.org/10.1093/cercor/bhq094

- Tillmann, B., Bharucha, J.J.: Effect of harmonic relatedness on the detection of temporal asynchronies. Percept. Psychophys. 64, 640–649 (2002). https://doi.org/10.3758/bf03194732

- Norman-Haignere, S.V., Kanwisher, N., McDermott, J.H., Conway, B.R.: Divergence in the functional organization of human and macaque auditory cortex revealed by fMRI responses to harmonic tones. Nat. Neurosci. 22, 1057–1060 (2019). https://doi.org/10.1038/s41593-019-0410-7

- Sloboda, J.A.: Empirical studies of emotional response to music. In: Cognitive bases of musical communication. pp. 33–46. American Psychological Association, Washington, DC, US (1992)

- Krumhansl, C.L.: An exploratory study of musical emotions and psychophysiology. Can. J. Exp. Psychol. Rev. Can. Psychol. Exp. 51, 336–353 (1997). https://doi.org/10.1037/1196-1961.51.4.336

- Blood, A.J., Zatorre, R.J., Bermudez, P., Evans, A.C.: Emotional responses to pleasant and unpleasant music correlate with activity in paralimbic brain regions. Nat. Neurosci. 2, 382–387 (1999). https://doi.org/10.1038/7299

- Blood, A.J., Zatorre, R.J.: Intensely pleasurable responses to music correlate with activity in brain regions implicated in reward and emotion. Proc. Natl. Acad. Sci. U. S. A. 98, 11818–11823 (2001). https://doi.org/10.1073/pnas.191355898